在这里我们对注意力的各种变种进行简单的介绍,主要包括:

- MHA(Multi-Head Attention)

- MQA(Multi-Query Attention)

- GQA(Grouped-Query Attention)

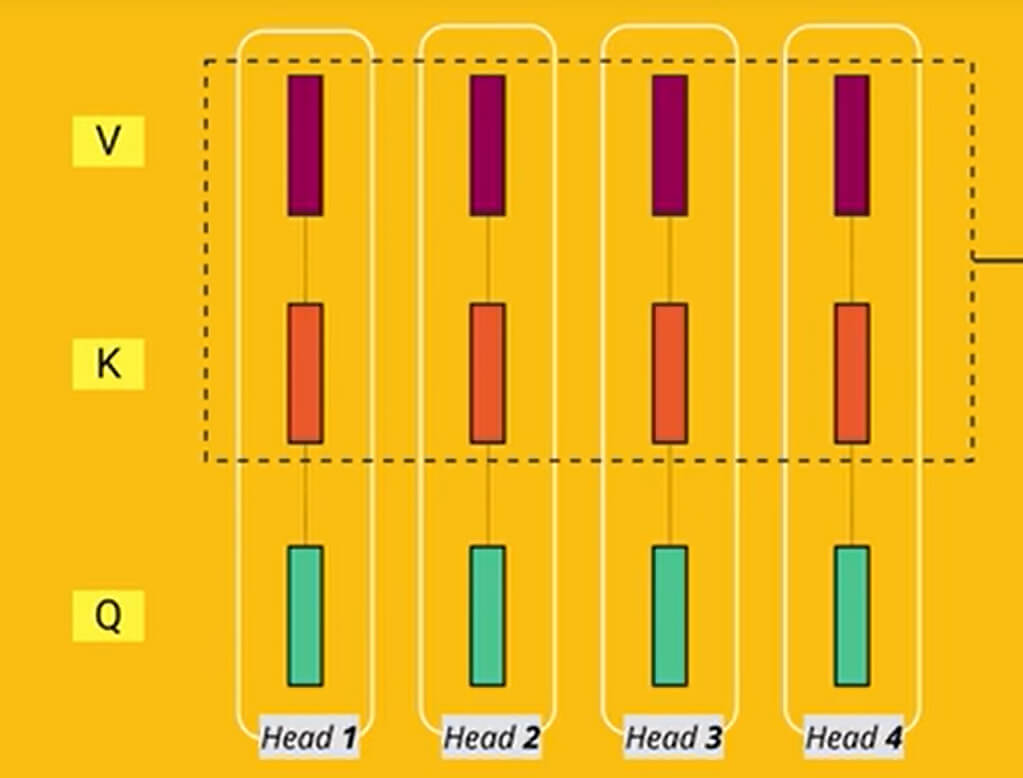

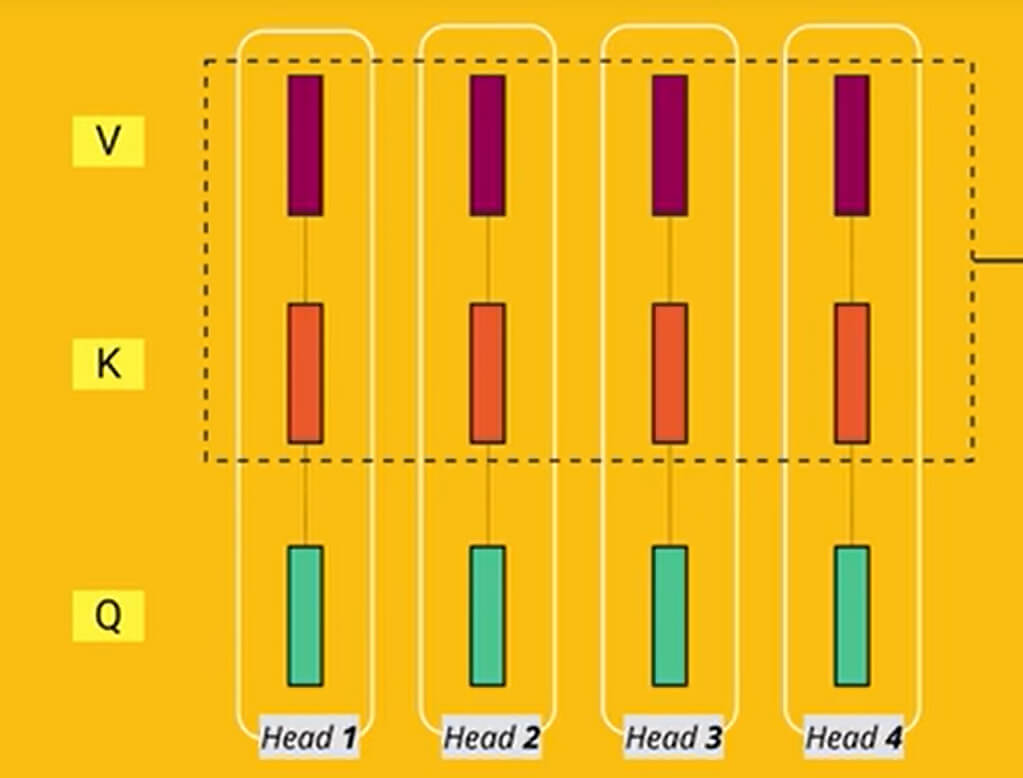

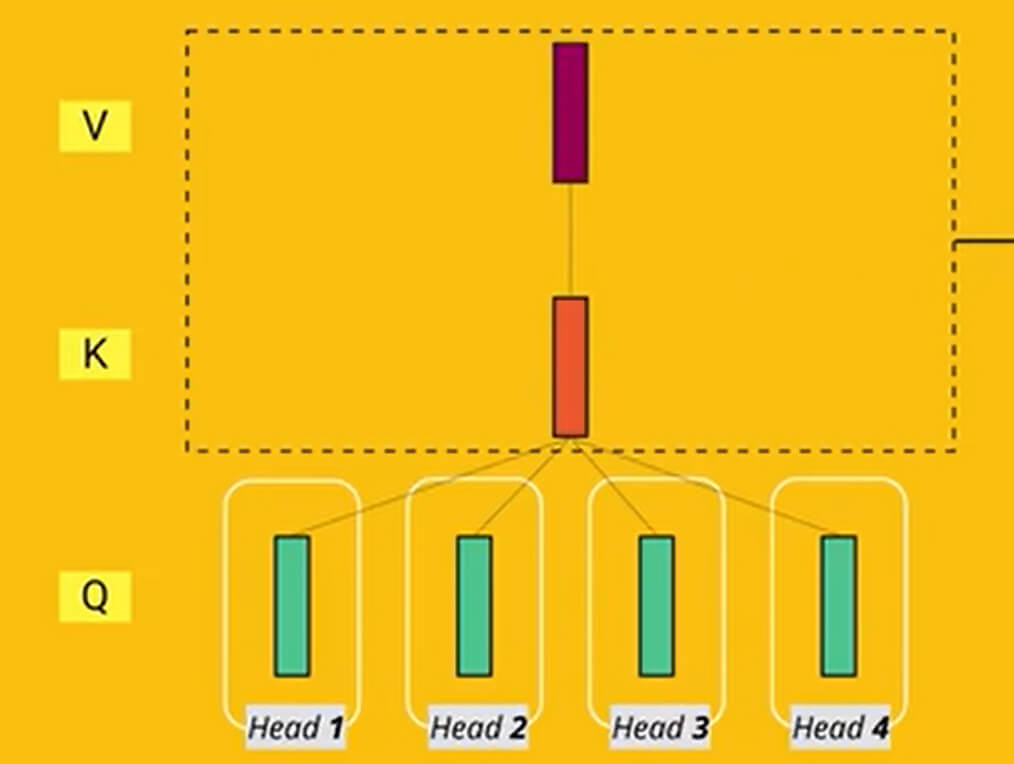

其中MHA是多头注意力,其网络结构如下图所示:

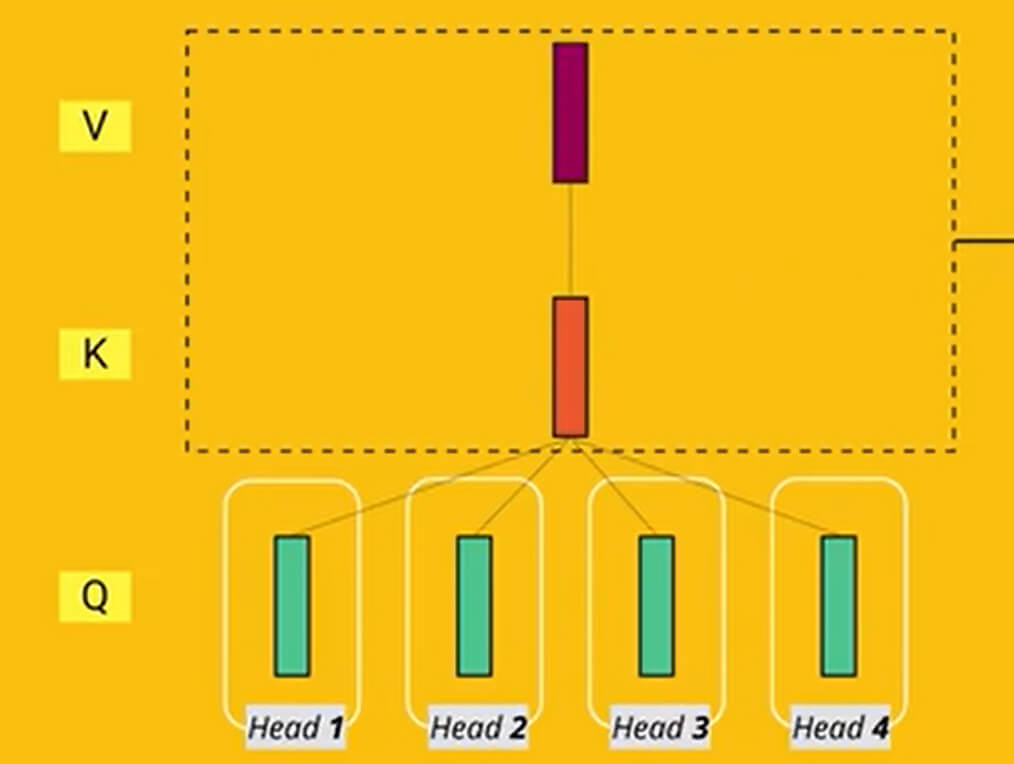

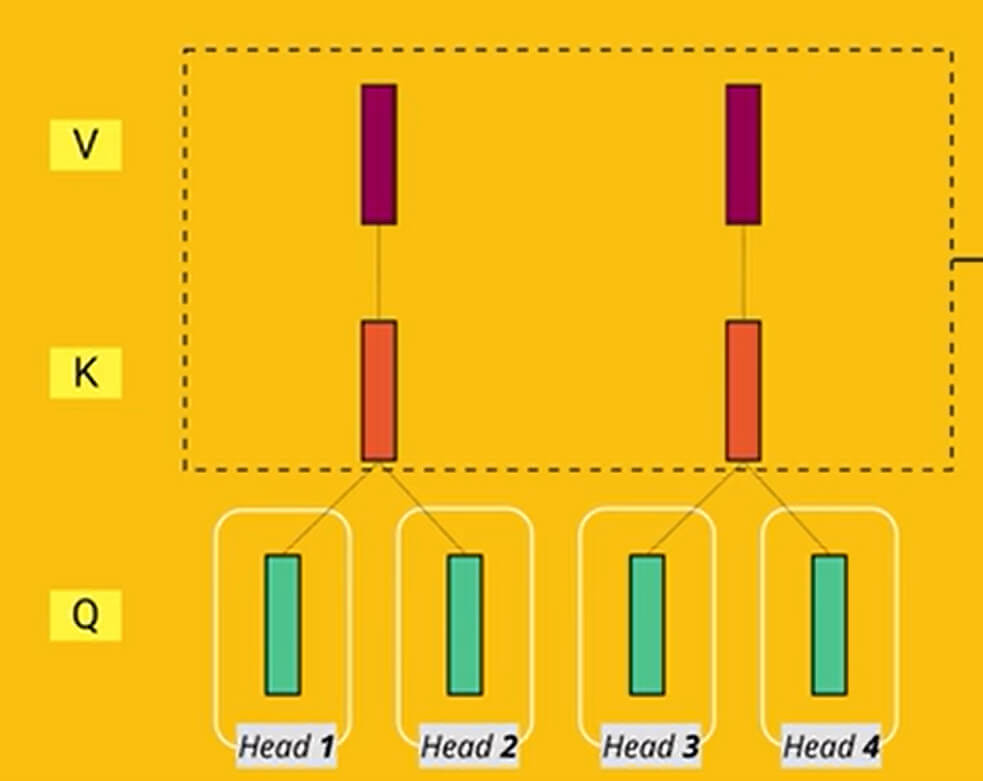

而MQA是将后面的K与V合并为1个,而为多个Q,其网络结构如下:

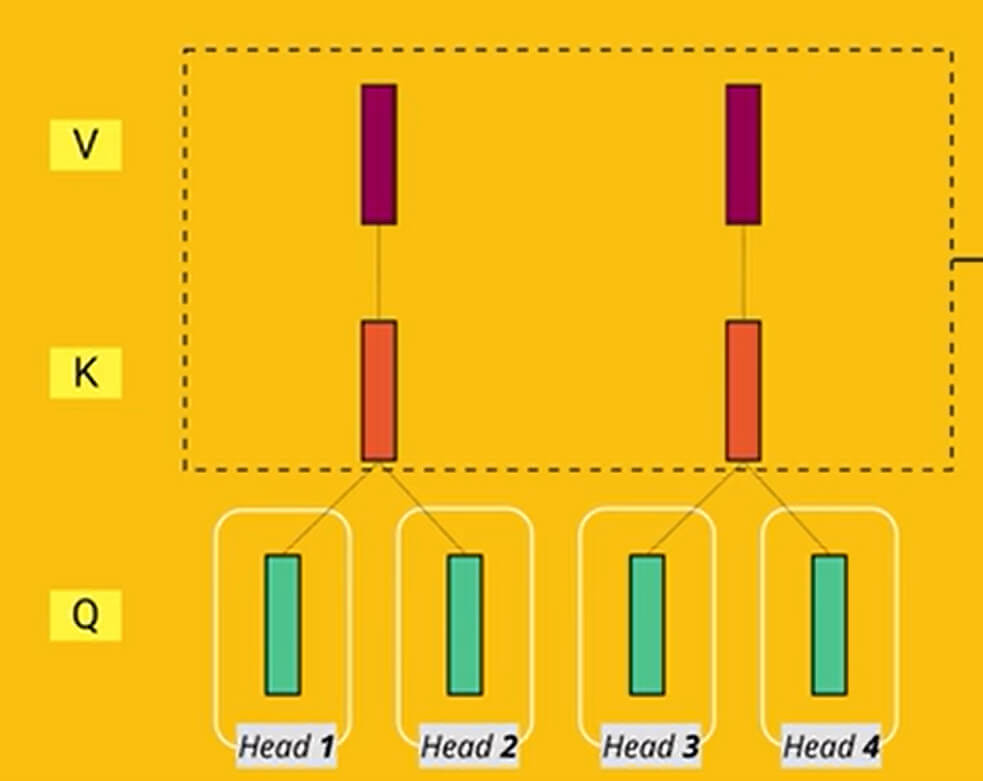

对于GQA,则将QKV分为多个组并共用,其网络结构如下:

参考视频:

如果喜欢这篇文章或对您有帮助,可以:[☕] 请我喝杯咖啡 | [💓] 小额赞助

在这里我们对注意力的各种变种进行简单的介绍,主要包括:

其中MHA是多头注意力,其网络结构如下图所示:

而MQA是将后面的K与V合并为1个,而为多个Q,其网络结构如下:

对于GQA,则将QKV分为多个组并共用,其网络结构如下:

参考视频: